Q(koshix):2024年のノーベル化学賞を受賞した,David Bakerと,{Demis Hassabis,John M. Jumper}の2組3名の業績とその受賞理由について,周辺知識や2組の関係性も含めて,できるだけ分かりやすく解説してください。なお,付録として,2024年のノーベル物理学賞とノーベル化学賞の両方のテーマに共通する意義を議論してください。A(Perplexity Pro):2024年のノーベル化学賞は、タンパク質科学の革新的な進歩に貢献した3名の研究者に授与されました。David Baker の業績David Baker(ワシントン大学シアトル校教授)は、計算機によるタンパク質設計の先駆的研究で賞の半分を受賞しました。・2003年に新しいタンパク質の設計に成功・その後、様々な革新的なタンパク質を創造・応用分野:医薬品、ワクチン、ナノ材料、微小センサーなどBaker の業績は、特定の機能を持つ全く新しいタンパク質を設計・構築する能力を科学者に与えました3。これは、薬剤開発、ワクチン設計、合成生物学などの分野に大きな影響を与える可能性があります。Demis Hassabis と John M. Jumper の業績Demis Hassabis と John M. Jumper(共にGoogle DeepMind所属)は、タンパク質構造予測の革新的な進歩により、賞の残り半分を共同受賞しました12。・AlphaFold2という人工知能モデルを開発・アミノ酸配列からタンパク質構造を高精度に予測可能・既知の約2億種類のタンパク質構造をほぼ全て予測彼らの開発したAIモデルは、50年来の科学的課題を解決し、190カ国以上の200万人以上の研究者に利用されています34。これにより、タンパク質の生物学的役割や応用可能性の理解が大きく進展しました。両者の関係性と意義Baker のタンパク質設計技術と、Hassabis・Jumper のタンパク質構造予測技術は、相補的な関係にあります。前者は新しいタンパク質を創造し、後者はその構造を予測することで、タンパク質科学の可能性を大きく広げました1。これらの発見は、理論科学を超えて、がんや遺伝性疾患を含む様々な病気の新しい治療法の開発につながる可能性があります1。付録:2024年のノーベル物理学賞と化学賞の共通点2024年のノーベル物理学賞は機械学習と人工ニューラルネットワークの基礎的発見に対して授与されました6。化学賞と物理学賞には、人工知能(AI)技術の科学研究への応用という共通点があります。1.AIの科学への応用:物理学賞はAIの基礎技術に関するものですが、化学賞ではその応用例(タンパク質構造予測)が評価されています。2.複雑な問題の解決:両分野とも、従来の方法では解決が困難だった複雑な問題にAIを活用しています。3.学際的アプローチ:物理学、化学、情報科学の境界を越えた研究が評価されており、科学の学際的な発展を示しています。4.実用的な影響:両分野の研究は、理論的な価値だけでなく、実際の応用(新薬開発、材料科学など)に大きな影響を与える可能性があります。これらの共通点は、AIが現代科学の様々な分野で重要な役割を果たしていることを示しており、今後の科学研究の方向性を示唆しています。

芥川龍之介が「蜘蛛の糸」を発表して百年。高二の秋の文化祭,クラスの仮装行列のテーマが 蜘蛛の糸だった。お釈迦様の極楽タワーの竹を近所から切り出し,地獄の焔と煙の絵を描いた。犍陀多に続いて蜘蛛の糸(登山部の赤いザイル)に群がる地獄の亡者だったころ。

2024年10月10日木曜日

タンパク質設計・構造予測

2024年10月9日水曜日

ニューラルネットワーク

Q(koshix):ホップフィールドネットワークとボルツマンマシンについて,ニューラルネットワーク全体の中でそれぞれがどのように位置づけられて,その後の発展にどういう影響を与えたかを,なるべく分かりやすく具体的に説明してください。A(Perplexity Pro):ホップフィールドネットワークとボルツマンマシンは、ニューラルネットワークの発展において重要な役割を果たした2つのモデルです。それぞれの位置づけと影響について説明します。ホップフィールドネットワークホップフィールドネットワークは、1982年にジョン・ホップフィールド(1933-)によって提案された再帰型ニューラルネットワークの一種です。

特徴と位置づけ・単一層のニューロンで構成され、各ニューロンが他のすべてのニューロンと双方向に結合しています。・連想記憶として機能し、不完全または雑音のある入力からパターンを復元できます。・エネルギー関数の最小化によってパターンを想起します。影響と発展1.記憶容量の向上:研究者たちは、ホップフィールドネットワークの記憶容量を向上させる方法を探求しました。例えば、ニューロン間の複雑な接続を導入することで、従来のモデルの2倍以上の記憶容量を実現しました。2.最適化問題への応用:ホップフィールドネットワークは、組み合わせ最適化問題の解決にも応用されました。3.深層学習への影響:現代の言語モデル(ChatGPTなど)の基盤となるTransformerネットワークは、ホップフィールドネットワークと類似した構造を持っています。4.脳機能のモデル化:記憶や認知プロセスの研究に応用され、神経科学の発展に寄与しました。ボルツマンマシンボルツマンマシンは、1985年にジェフリー・ヒントン(1947-)らによって提案された確率的ニューラルネットワークモデルです。特徴と位置づけ・対称的に結合されたニューロン様ユニットで構成され、確率的に on/off を決定します。・二値データセットから興味深い特徴を発見する能力を持ちます。・学習アルゴリズムは単純ですが、多層構造では非常に遅くなる傾向があります。影響と発展1.制限ボルツマンマシン (RBM):ボルツマンマシンを簡略化した RBM は、深層信念ネットワーク (DBN) の基本構成要素となりました。2.深層学習の前駆:RBM は、深層ニューラルネットワークの事前学習に使用され、深層学習ブームの先駆けとなりました。3.生成モデルへの貢献:ボルツマンマシンの考え方は、変分オートエンコーダ (VAE) や生成敵対的ネットワーク (GAN) などの現代の生成モデルの発展に影響を与えました。4.確率的モデリング:機械学習における確率的アプローチの重要性を示し、後の研究に影響を与えました。5.教師あり学習への応用:教師あり RBM は、分類タスクのための興味深い分布設定を提供しました。これらのモデルは、ニューラルネットワークの理論的基礎を築き、現代の深層学習技術の発展に大きく貢献しました。ホップフィールドネットワークは主に連想記憶と最適化問題に、ボルツマンマシンは特徴学習と生成モデリングに影響を与え、両者ともに現代のAI技術の礎となっています。

2024年3月1日金曜日

1.58ビット

BitNetのような最近の研究は、1ビット大規模言語モデル(LLM)の新しい時代への道を開いている。この研究では、1ビットLLMのバリエーションであるBitNet b1.58を紹介する。BitNet b1.58では、LLMのすべてのパラメータ(重み)が3値{-1, 0, 1}である。このLLMは、同じモデルサイズと同じ学習トークンを持つ全精度(FP16またはBF16)Transformer LLMとパープレキシティとエンドタスクパフォーマンスの両面で一致し、レイテンシ、メモリ、スループット、エネルギー消費の点で大幅にコスト効率が高い。さらに深いことに、1.58ビットLLMは、高性能でコスト効率に優れた新世代のLLMを訓練するための新しいスケーリング則とレシピを定義している。さらに、新しい計算パラダイムを可能にし、1ビットLLMに最適化された特定のハードウェアを設計するための扉を開く。

もし,これが本当ならば,現在のNVIDIAのGPU ブームは一過性のモノになってしまうかもしれない。LLMには新しいアーキテクチャの半導体チップが必要になるのだから。

なお,1.58bit は {-1,0,1}の3値の情報量,$\log_2 3 = \dfrac{\log 3}{\log 2} = 1.58...$ から来ている。

[1]驚異の1ビットLLMを試す。果たして本当に学習できるのか?(shi3z)

2023年12月21日木曜日

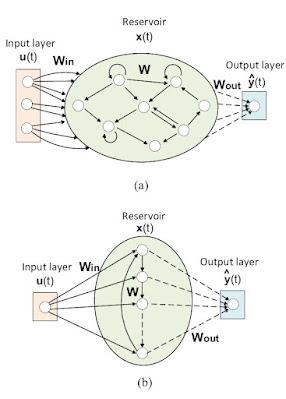

リザーバー・コンピューティング

Reservoir computing(リザーバーコンピューティング)は、再帰ニューラルネットワークに着想を得た比較的新しい計算フレームワークです。この手法は、入力信号をリザーバーと呼ばれる固定された非線形システムのダイナミクスを使用して、高次元の計算空間にマッピングすることによって機能します。このリザーバーは、水のバケツや回路などの物理的なシステムであるか、微分方程式の系などの数学的なモデルであることができます。その後、リザーバーの出力は線形の読み出し関数を使用して読み取られます。この読み出し関数は、リザーバーの状態と所望の出力との関係を学習するためにトレーニングできます。図:リザーバーコンピューティングアーキテクチャ(編者注: Rossello (2018)の図 [1] へ勝手にリンク引用しているBard)リザーバーコンピューティングの利点の一つは、非常に効率的であることです。リザーバーは非常に単純であり、読み出し関数は比較的単純で速いアルゴリズムである線形回帰を使用して学習できます。これにより、低消費電力とリアルタイムのパフォーマンスが重要なアプリケーションに適しています。リザーバーコンピューティングのもう一つの利点は、非常に柔軟であることです。同じリザーバーは、読み出し関数を変更するだけでさまざまなタスクを学習するのに使用できます。これにより、タスクが事前にはわからない場合や、タスクが時間とともに変化する場合に適しています。リザーバーコンピューティングはまだ比較的新しい分野ですが、計算の仕方を革新する可能性があります。既に音声認識、画像認識、およびロボット制御など、さまざまなアプリケーションで使用されています。以下はリザーバーコンピューティングに関するいくつかの追加の詳細です:・リザーバーは通常、多くの内部状態を持つ高次元システムです。これらの状態は複雑な方法で相互作用し、リザーバーが非線形関数を計算できるようにします。・読み出し関数は通常、リザーバーの状態の線形関数です。この関数は、所望の入出力関係の例などのトレーニングデータを使用して学習できます。・リザーバーコンピューティングは、サポートベクターマシンやディープラーニングなどの他の機械学習技術と組み合わせて使用されることがよくあります。これにより、システムの精度とパフォーマンスを向上させるのに役立ちます。

2021年7月22日木曜日

AlphaFold2(2)

AlphaFold2(1)からの続き

再びAlphaFold2が話題になっていたのでなにかと思ったら,「米Alphabet傘下の英DeepMindが、遺伝子配列情報からタンパク質の立体構造を解析するAI「AlphaFold v2.0」(以下AlphaFold2)をGitHub上で無償公開し、ネット上で注目を集めている」ということだった。

AlphaFold2解体新書をみれば詳細がわかりそうな気がする。論文は,Highly accurate protein structure prediction with AlphaFoldであり,実装が,alphafold@github となっている。ただし,実際にインストールしようとすると,最低でも,2.5TB以上のSSD/HDD容量 (必須),CUDA11に対応しているNVIDIA製GPU(推奨),大容量(32GB以上)のRAM(推奨)が必要なので素人は手を出してはいけません。

大学に進学するとき,第1志望を物理学科,第2志望を生物学科にしたほど,生物学というか生命科学がこれからは重要だという認識があった。大学の教養部では巌佐耕三先生の生物学を履修した。AlphaFold2のニュースから阪大で受けた生物学の授業が連想された。その授業の先生の名前が思い出せなくて調べていたら,巌佐耕三先生だったということがわかったが,2017年に亡くなられていた(阪大理生物同窓会誌 Vol. 14 2017)。

筑摩書房の「生物学のすすめ」をテキストとしていた巌佐先生の授業でたたきこまれたのが,生物の本質が,DNA/RNAからアミノ酸配列(1次構造)が定まり,これからタンパク質の立体構造(3次構造)が決まって様々な生理機能を果たすということに依拠しているということだった。

つまり,ゲノム配列を簡単に求められるようになった時代に,それからタンパク質の立体構造を容易に推定できることの重要性がどれほどのものかということだろう。

それにしても,物理科学も生物科学も機械学習全盛の時代に相転移しつつある。

2020年12月2日水曜日

AlphaFold2(1)

twitter界隈では,AlphaFold2が騒ぎになっている。タンパク質の立体構造を求める競技でこれまでの手法から飛び抜けた成果を得る深層学習の方法が考案されたということらしいが,専門外の自乗なのでよくわからない。田口善弘さんが相当に凄いといってるのでたぶんそうなのだろうと思う。

タンパク質の立体構造というとDNAの立体構造と並んで,X線結晶解析の応用分野の花形だったような気がする。教養の化学の授業担当が,阪大の吹田にあった蛋白質研究所(1958-)助教授の芦田玉一先生(後に名大工学部)で,デュワーの「新しい化学入門」が教科書だった。この教科書は量子力学の成果をフルに生かした化学の教科書であり,物理学科の我々にはふさわしいものだったかもしれない。

五月祭のときだったろうか,何かのきっかけで,芦田先生にお願いして物理学科の数名でタンパク質研究所を見学させてもらった。たぶん,佐藤秀明くんが言い出しっぺで,みんなでそれに便乗したのではなかったか。日本で初めて構造が決定されたタンパク質であるカツオ・チトクロームCの立体構造模型を見せていただいた。秀明くんは,英語の藤井治彦先生の授業でも,ジェームズ・ワトソンの「二重らせん」をテキストにできないかという交渉をしていたのだけれど,こちらは残念ながら却下されたのであった。

2019年12月12日木曜日

機械学習と公平性

電子情報通信学会 情報論的学習理論と機械学習研究会の三者が連名で「機械学習と公平性に関する声明」を発表した。

声明を出した背景としては,2018年10月にAmazon.comが採用時に利用していた機械学習システムが女性に対して不利益に働くことに気づいてこのシステムの利用を停止したという報道を挙げている。

しかし,それでは時間が開きすぎている。直接書かれてはいないが,東京大学大学院情報学環・学際情報学府の特任准教授が11月20日にTwitter上で差別的な発言をして,それが炎上したことがきっかけになっている。

情報学環長・学際情報学府長の越塚登先生は,11月24日に学内向け文書,11月26日に学生向けMLでメッセージを発しており,それを11月28日には公開している。それなりに迅速な対応がなされたと思う。

一方,当該教員の属する寄付講座についても,マネックス証券はただちに見解を発表し,寄付の停止に至るようだ。

機械学習が社会にもたらす影響は非常に大きなものになりそうだ。センサーが張り巡らされた社会を,センサーの塊をつねに携帯しながら活動する個人が,ほとんどの情報を無担保に預けながら,ブラックボックスにつつまれたプロセスで評価される社会だ。機械学習の説明責任(というか説明システムの理論的な研究や開発)についての議論もスタートしている。

P. S. 大澤昇平はネトウヨにアピールしながら寄付を集め始めたようだ(2019.12.12)。

[1]学環・学府特任准教授の不適切な書き込みに関する学生へのメッセージ(2019.11.28)

[2]学環・学府特任准教授の不適切な書き込み等に関する調査委員会の設置について(2019.11.28)

[3]学生留学生委員会から情報学環・学際情報学府の学生の皆さんへ(2019.11.29)

[4]大澤昇平特任准教授による2019.12.12付のSNS書込みに対する見解(2019.12.13)

[5]寄付講座担当特任准教授の不適切な書き込みに関する見解(マネックス 2019.11.24)

[6]寄付講座担当特任准教授の不適切な書き込みに関する当社の見解について(オークファン 2019.11.25)

[7]Japanese academia appears soft on racism(ASIA TIMES 2019.11.25)

[8]Announcement: terminating our business relationship with Daisy AI (Streamer 2019.11.27)

2019年6月16日日曜日

Software 2.0

問題解決のために用いられる従来のプログラム(C++,Java,・・・)をソフトウェア1.0とよび,ニューラルネットワークによる問題解決を1つのツールとして見るのではなく,ソフトウェア2.0として考えようということを提案している。

すなわちニューラルネットワークの重みがプログラムに相当すると考えるのである。この重みの数(ニューラルネットワークのノード数)は膨大な数になることから,従来のプログラムのようにアルゴリズムを考えて人間がコード化するプログラミングとは質的に違ったものになっている。そして,その適応範囲が,画像認識,音声認識,機械翻訳,ゲームと広がっている。

もちろん,ソフトウェア2.0がすべてのソフトウェアによる問題解決をカバーすることはできないので,ソフトウェア1.0と共存することになるが,ニューラルネットワークについての一つの見方を提供するものである。そして,これが,サイエンスにおいてニューラルネットワーク(ディープラーニング)を利用することが持つ意味について,再考させることにつながるのかもしれない。

2019年6月2日日曜日

AI Feynman(4)

2018年に発表されたウーとテグマークの論文 "Toward an AI Physicist for Unsupervised Learning"は,AI Feynman 論文に先行するものだ。2018年のインターネットでは,AI物理学者が仮想現実の物理法則を発見したものとして話題になっていた。

その要約は次のようなものである。

物理学でよく用いられる4つの戦略を使用して,教師なし機械学習を改善するという課題に挑戦する。その4つは,分割統治,オッカムのかみそり,統一,そして絶え間ない学習である。1つのモデルを使ってすべてを学ぶのではなく,学習と「理論」の操作を中心に置いた新しいパラダイムを提案する。それは(過去の観測から)将来を予測し,その予測が正しい領域を定めるものだ。特に,各理論がその比較的有利な領域に特化するための新しい一般化平均損失,および不良データを除いて理論を単純な数式にまとめることを目指す区別可能な記述長を導入する。理論は「理論ハブ」に格納され,そこでは学習された理論を継続的に統合し,新しい環境に出会ったときに理論を提案することができる。我々は,実装した「AI Physicist」学習エージェントを,しだいに複雑化する環境でテストする。重力,電磁気力,調和運動,弾性衝突などのランダムな組み合わせを含む仮想世界における物体の軌道の教師なし学習を行う。我々の学習エージェントは,同等の複雑さの順伝搬型ニューラルネットより速く学習し,約10億分の1の平均二乗予測誤差を与える。また,整数や有理数の理論パラメータを正しく予言する。この学習エージェントは区分的に一定の力が働く場における非線形カオス二重振り子についても,異なる運動則をもつ領域をうまく同定することができた。

2019年6月1日土曜日

AI Feynman(3)

機械学習と物理で紹介したように,日本物理学会誌では,人工知能と物理学というシリーズが始まっている。第1回目に神嶌敏弘さんが,機械学習の分野の全体像と歴史の概観をしているが,データマイニング・機械学習分野の概要という資料もわかりやすい。

神嶌さんの物理学会誌の特集記事に「変わりゆく機械学習と変わらない機械学習」というのがある。機械学習の自然科学での活用の節で,ドミンゴの "The Master Algorithm" からの引用として,自然科学の研究をブラーエ,ケプラー,ニュートンの業績になぞらえて三段階に分類してとらえることができると紹介している。なんのことはない武谷三男の三段階論ではないか。

「実験データを集めるブラーエの段階, 経験則を発見するケプラーの段階,そしてその経験則の背後の理論を見つけ出すニュートンの段階である」というのは武谷三段階論の現象論,実体論,本質論に対応している。それぞれに対して,データマイニング・機械学習・深層学習・AI(それぞれの分野の概念的な構造関係が十分理解できていないので暫定的に並列にしている)で何ができるかを考えることができる。

テグマークのAI Feynmanは,実体論なのだろうか,本質論なのだろうか。あるいは階層の異る現象論なのだろうか(広重徹ならばそのような三段階論による当嵌めの構図それ自体に意義をとなえるかもしれない)。

(AI Feynman(4)に続く)

2019年5月31日金曜日

AI Feynman(2)

ニューラルネットワークあるいはディープラーニングを自然科学とくに物理学に応用するという話は昔からあった。30年近く前にもニューラルネットワークで原子核の結合エネルギーを分析するような話題を見かけたことがあるような気がする。

物理科学でのニューラルネットワーク/ディープラーニングの利用というと次のようなものが想像できた。望遠鏡や加速器で得られたデータを分析してシグナルを発見する。物質の合成過程の膨大なデータから目的の性質を持つ組み合わせを推定する。などなど。

で,最近は こんな本が出版されるまでに至る。

「ディープラーニングと物理学 原理がわかる、応用ができる(田中・富谷・橋本)」

もう一歩進めると,いわゆるAI(機械学習)で物理学の法則を発見することができるのかが問題になる。理論が予め存在しその方程式のパラメータを探すのではなく,理論それ自身を作り出すことができるかだ。テグマークの論文はその方向の試みなのだろう。

(AI Feynman(3)に続く)

2019年5月30日木曜日

AI Feynman(1)

さて,その要約は,次のようなものだった。

物理学と人工知能(AI)の双方にとって核心的な課題の一つは数式回帰である。つまり,未知関数からのデータに一致する数式表現を発見することである。 この問題は原理的にNP困難である可能性が高いが,実用的な興味の対象となる関数はしばしば対称性,分離性,合成性および他の単純化できる特性を示す。 この精神のもとで,我々は,ニューラルネットワークと物理学に着想を得た技術を組み合わせた再帰的多次元記号回帰アルゴリズムを開発した。 我々はそれを「ファインマン物理学講義」からの100の方程式に適用し,そのアルゴリズムはすべてを発見する。従来のソフトウェアでは71だけが見つかった。より困難なテストセットでも,到達水準を15%から90%に向上させた。(AI Feynman(2)に続く)

2019年3月16日土曜日

機械学習と物理

1(一般シンポジウム講演)はじめに

阪大理・物理,橋本幸士

2(一般シンポジウム講演)物性物理のグランドチャレンジに対する重回帰分析と機械学習

東大院工,今田正俊

3(一般シンポジウム講演)強い相互作用の最難問 — 中性子星の状態方程式

東大理・物理・原子核理論,福嶋健二

4(一般シンポジウム講演)データ駆動手法による相関物質の予測と理解

産総研 CD-FMat,三宅隆

5(一般シンポジウム講演)機械学習によるマルコフ連鎖モンテカルロ法の高速化へ向けて

理研(AIP/iTHEMS), 慶應大・数理,田中章詞

6(一般シンポジウム講演)機械学習による特徴抽出と,繰り込み群や熱力学との関係

OIST,船井正太郎

7(一般シンポジウム講演)広域撮像宇宙サーベイによるビッグデータ宇宙論

東大理・物理・宇宙理論,吉田直紀

8(一般シンポジウム講演)量子力学と機械学習の数理

東北大院情報科学,大関真之

ちなみに,昨年の2018年度日本物理学会科学セミナーのテーマも「AI(人工知能)と物理学(東京大学駒場キャンパス 数理科学研究棟 大講義室)」であった。そのプログラムは以下の通り(ちょっと被っている)。

8月11日(土・祝)10:00-16:30

1 はじめに

日本物理学会会長 川村 光

2 情報処理技術としてのAI

中島 秀之(札幌市立大学 学長)

3 思考力を競うゲームの人工知能技術発展の歴史と現状

保木 邦仁(電気通信大学大学院情報理工学研究科 准教授)

4 広域宇宙撮像データを用いたビッグデータ宇宙論

吉田 直紀(東京大学大学院理学系研究科 教授)

5 量子コンピュータが人工知能を加速する

大関 真之(東北大学大学院情報科学研究科 准教授)

6 深層学習と時空

橋本 幸士 (大阪大学大学院理学研究科 教授)

8月12日(日)10:00-16:40

7 深層学習とは何か、そしてどんなことが出来るようになっているのか

瀧 雅人(理化学研究所数理創造プログラム(iTHEMS) 上級研究員)

8 多層畳み込みニューラルネットワークで求めた量子相転移の相図

大槻 東巳(上智大学理工学部機能創造理工学科 教授)

9 人工知能と脳科学

甘利 俊一(理化学研究所脳神経科学研究センター 特別顧問)

10 量子力学の問題をニューラルネットワークで解く

斎藤 弘樹(電気通信大学大学院情報理工学研究科 教授)

11 AI は物理において何の役に立つか?

寺倉 清之(物質・材料研究機構 名誉フェロー・エグゼクティブアドバイザー)

12 おわりに

日本物理学会科学セミナー担当理事 迫田 和彰

参考:Quantum Machine Learning(Wikipedia)

List of Acronyms

ANN: Artificial neural network

BM: Boltzmann machine

BN: Bayesian network

CDL: Classical deep learning

CML: Classical machine learning

HMM: Hidden Markov model

HQMM: Hidden quantum Markov model

k-NN: k-nearest neighbours

NMR: Nuclear magnetic resonance

PCA: Principal component analysis

QBN: Quantum Bayesian network

QDL: Quantum deep learning

QML: Quantum machine learning

QPCA: Quantum principal component analysis

QRAM: Quantum random access memory

RAM: Random access memory

SQW: Stochastic quantum walk

SVM: Support vector machine

WNN: Weightless neural network